エンジニアの大場です。

2025年5月にUnity 6.2 Beta版がリリースされたので目玉機能Unity AIを触ってみました。

目次

- 1. Unity AIとは

- 2. 旧Unity Museの機能

- 3. 旧Unity Sentisの機能

- 4. まとめ

1. Unity AIとは

Unity 6.2から提供されるエージェント型&生成型AIツール。

(2025年7月現在はUnity 6.2 Beta)

Unity MuseとUnity Sentisが廃止されUnity AIに統合された。

- Unity Muse

- エディター向けのAI

- テクスチャ, アニメーション, 音声, マテリアルなどの生成に加えてチャットアシスタントAIなど

- インターネット接続で動作可能

- Unity Sentis (※現在はUnity Interface Engineと名称変更)

- ランタイム向けのAI

- 機械学習(ONNX形式のモデル)をゲームに組み込み。物体検出や音声認識など

- ローカル環境で動作可能

2. 旧Unity Museの機能

2-1. 料金形態

AI(Unity Muse)の機能を使うにはポイントが必要。

- Unity Pro、Unity Enterprise、Unity Industryは毎月割り当てポイントがある

- 別途購入することが可能なポイントがある

- 金額はUnity 6.2が正式版になった時に発表

- ※Beta期間中は無料

2-2. 「Unity AI Models and Partners」の要約

- データは開発者の所有権となる

- データはモデルのトレーニングとして利用されない

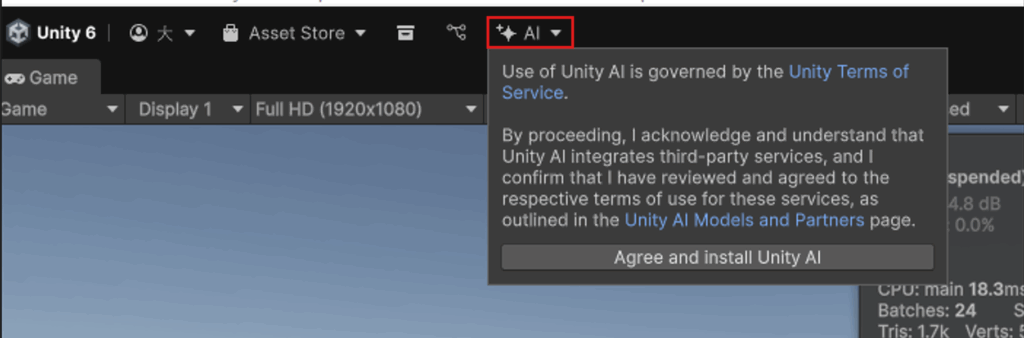

2-3. インストールとメニューについて

メニューから同意してインストールする。

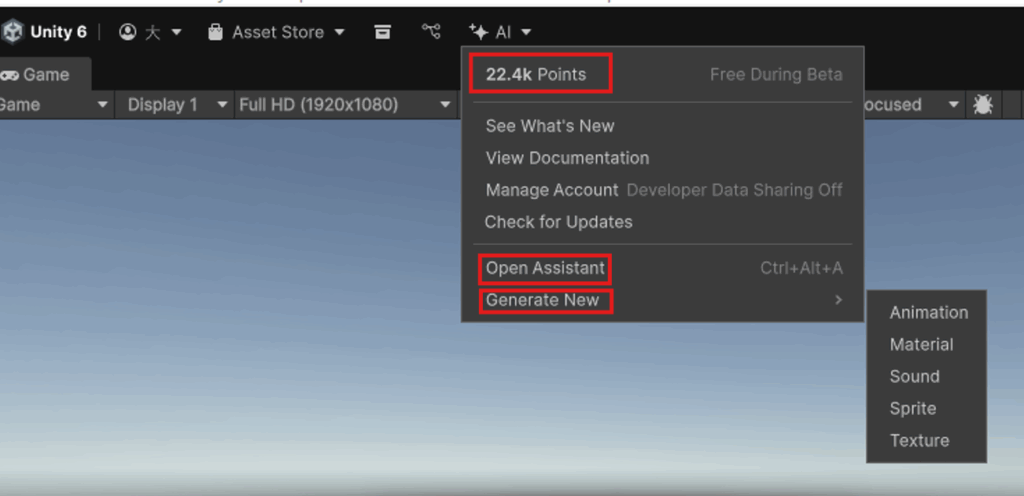

インストールが終わると以下のようなメニュー画面に変ります。

上から順に

- AIポイント。こちらを消費してAI機能を利用する。

- アシスタントチャットAIのウィンドウを開く

- 生成AIのウィンドウを開く

- Animation

- Material

- Sound

- Sprite

- Texture

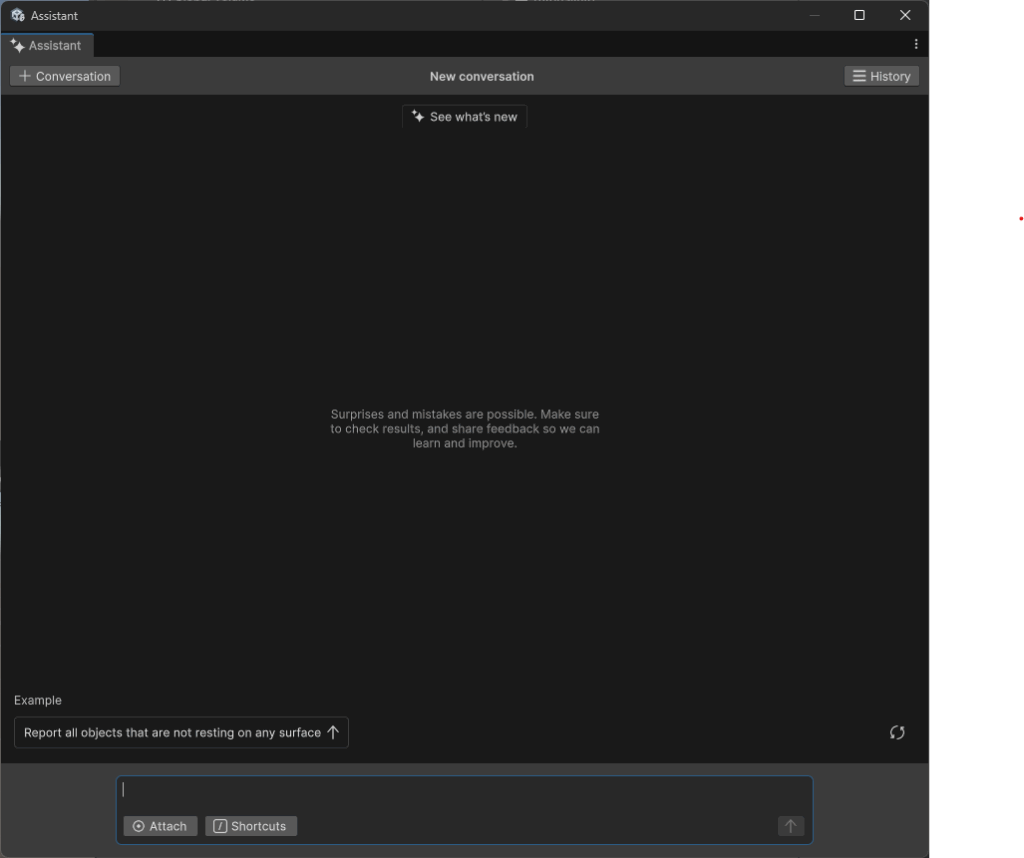

2-4. Assistant

操作モードは3つあり、文章入力前に以下のショートカットを入力するとよい

- /ask

- プロジェクト ファイルを変更せずに回答

- プロジェクト固有の詳細を取得

- ベストプラクティス

- /run

- Unity エディターで直接変更を実行できる

- /code

- スクリプトを生成

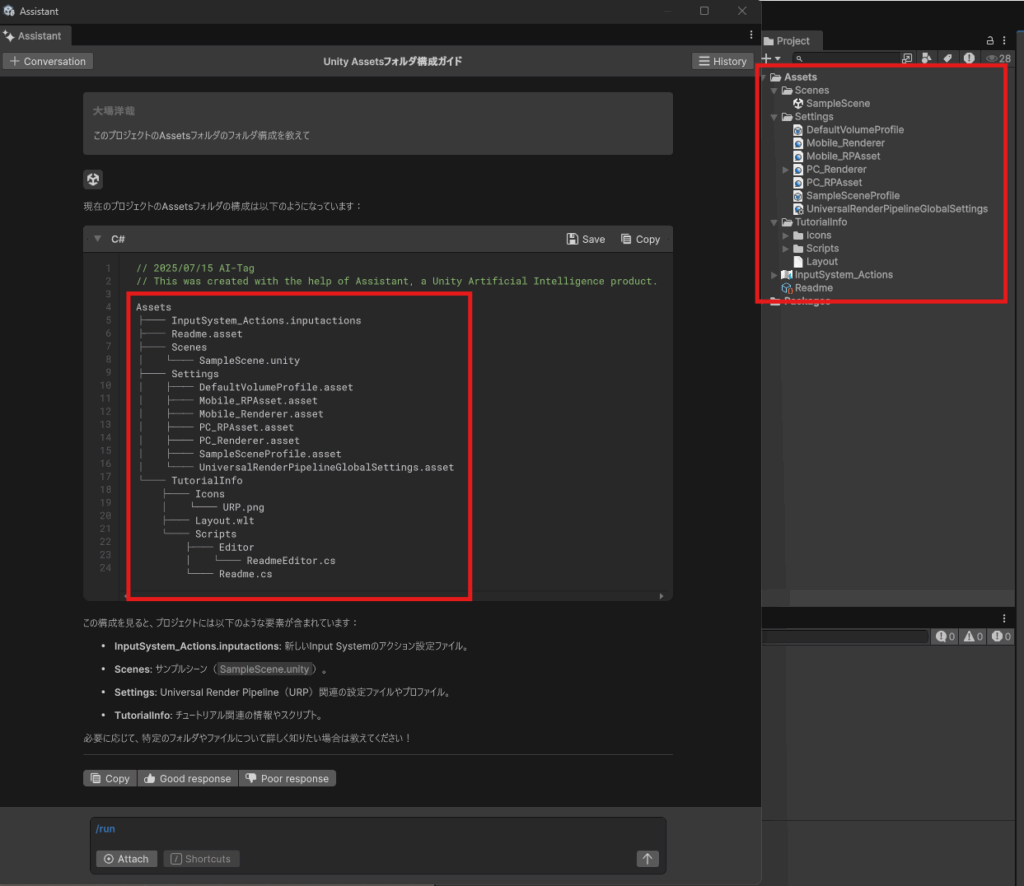

2-4-1. /askモード

「このプロジェクトのAssetsフォルダのフォルダ構成を教えて」と質問するとプロジェクトのフォルダ構成を教えてくれます。

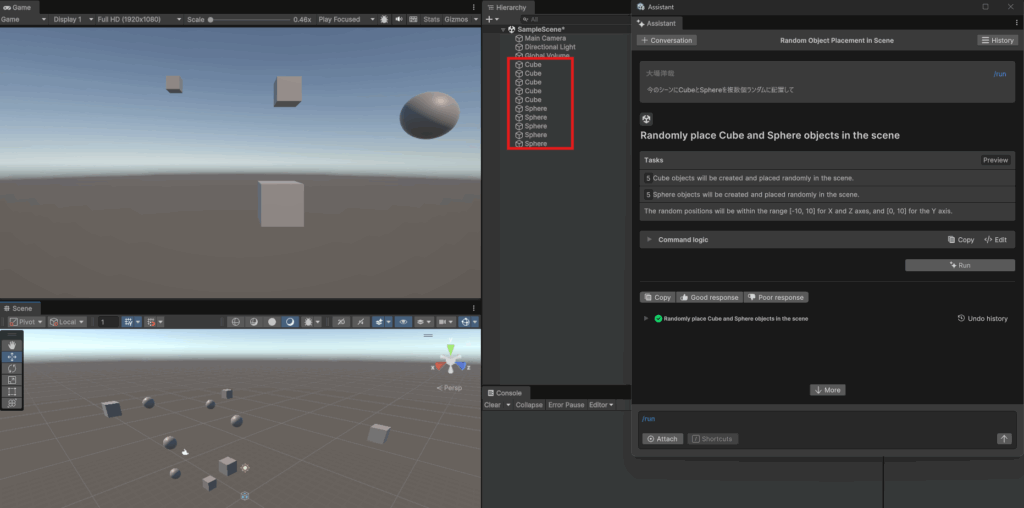

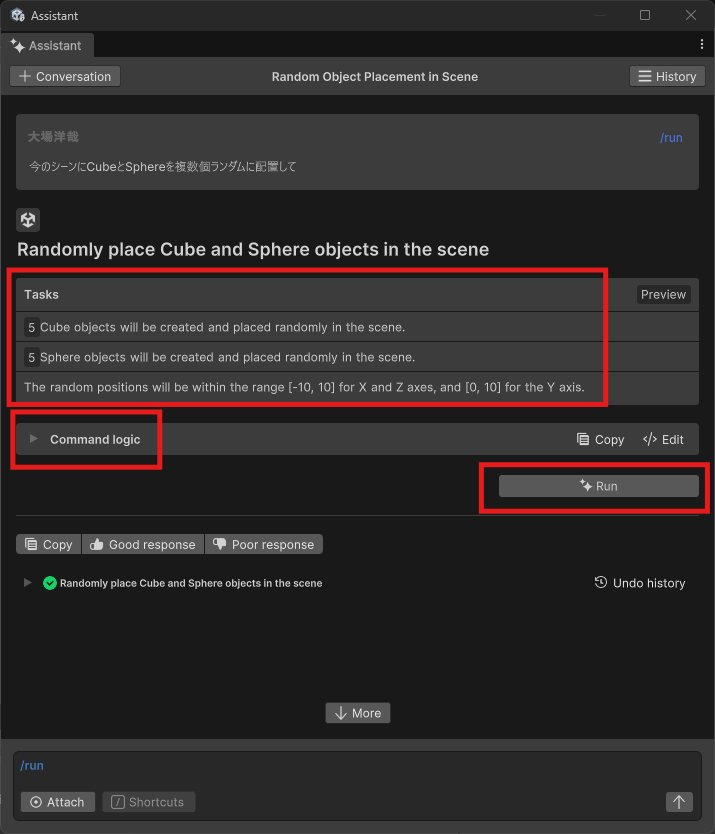

2-4-2. /runモード

「今のシーンにCubeとSphereを複数個ランダムに配置して」と命令すると実行してくれます。

Tasksが実行タスクの順番が書いてあり、Command logicで実行スクリプトが見れます。

命令を実行するにはRunボタンを押します。

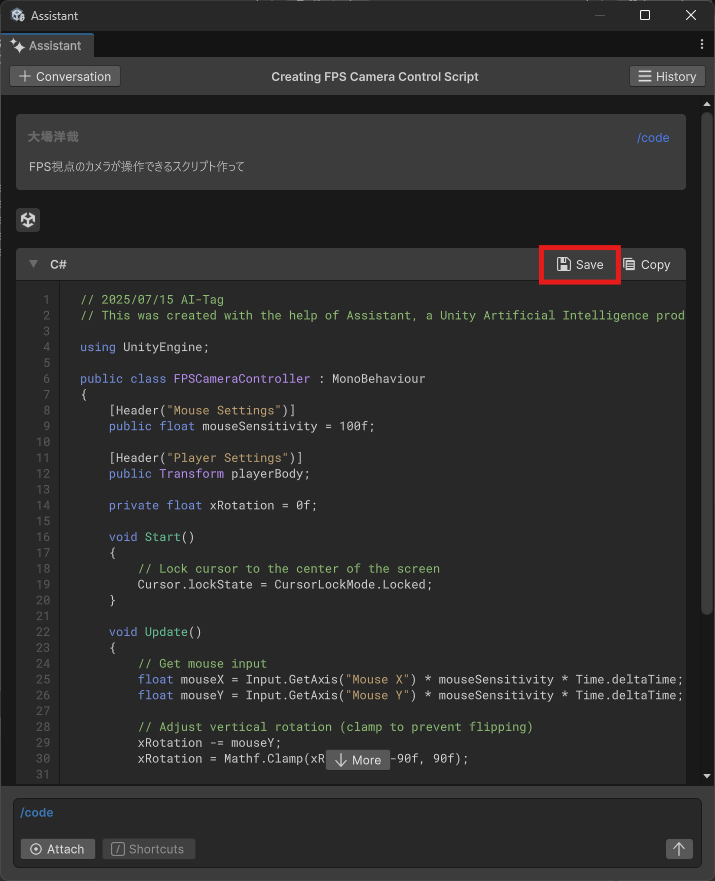

2-4-3. /codeモード

Saveボタンを押すことでプロジェクトに保存できます。

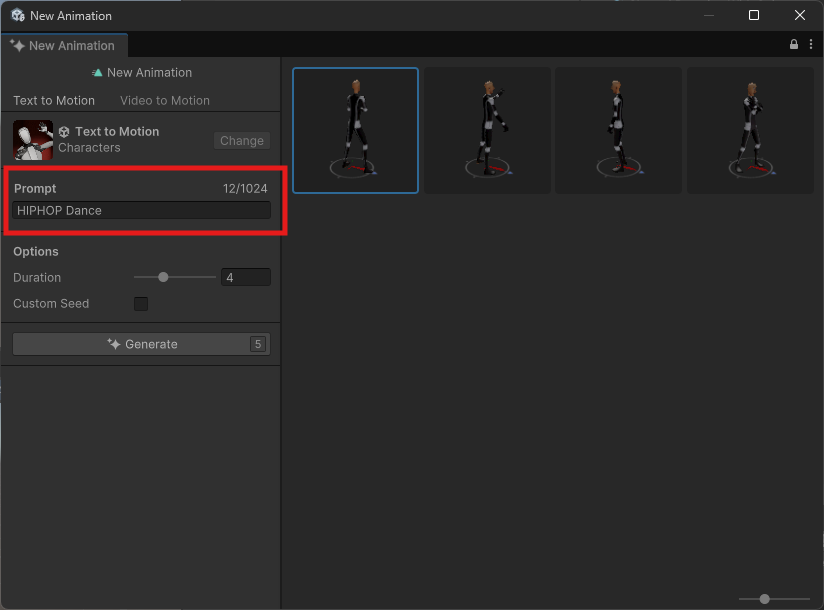

2-5. Animation Generate

2-5-1. Text to Motion

テキストからアニメーション(Animation Clip)を作成します。

現在のバージョンではHumanoidのアニメーション限定でした。

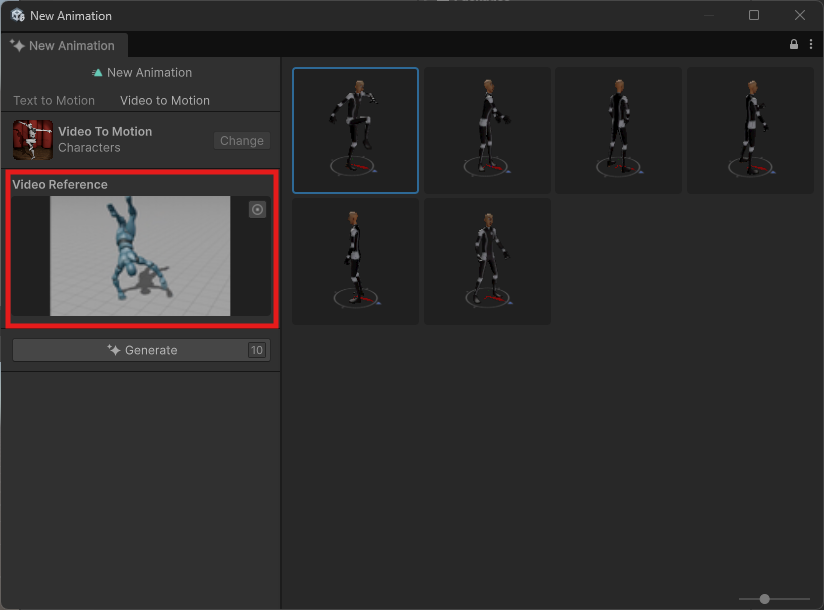

2-5-2. Video to Motion

動画ファイルからアニメーション生成ができます。

赤枠部分にAssetsフォルダにインポートしたVideo Clip(.mp4)を入れます。

こちらも現在のバージョンではHumanoidのアニメーション限定でした。

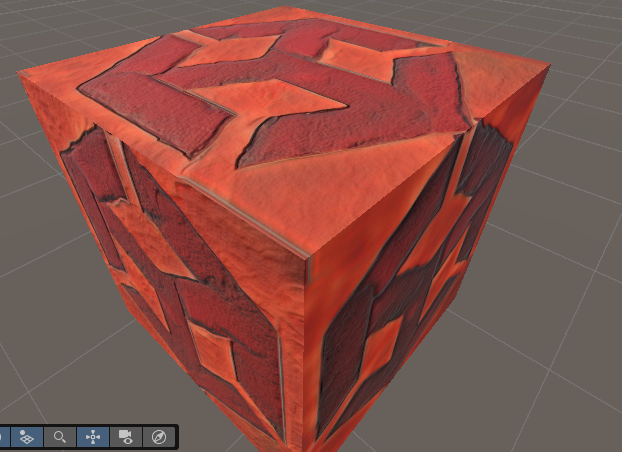

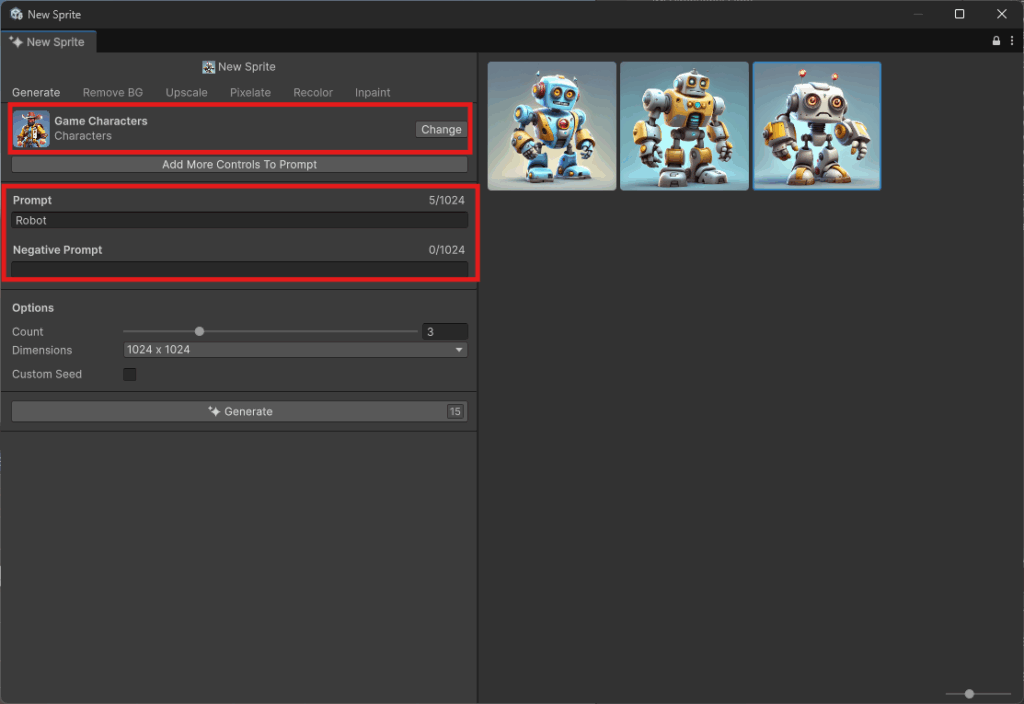

2-6. Material Generate

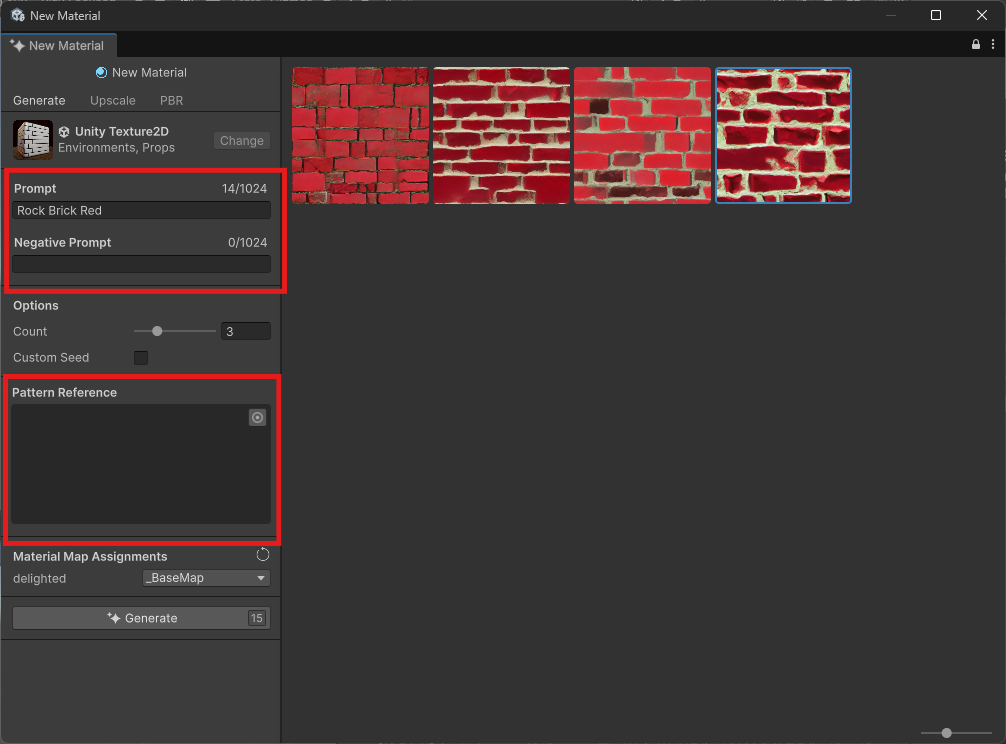

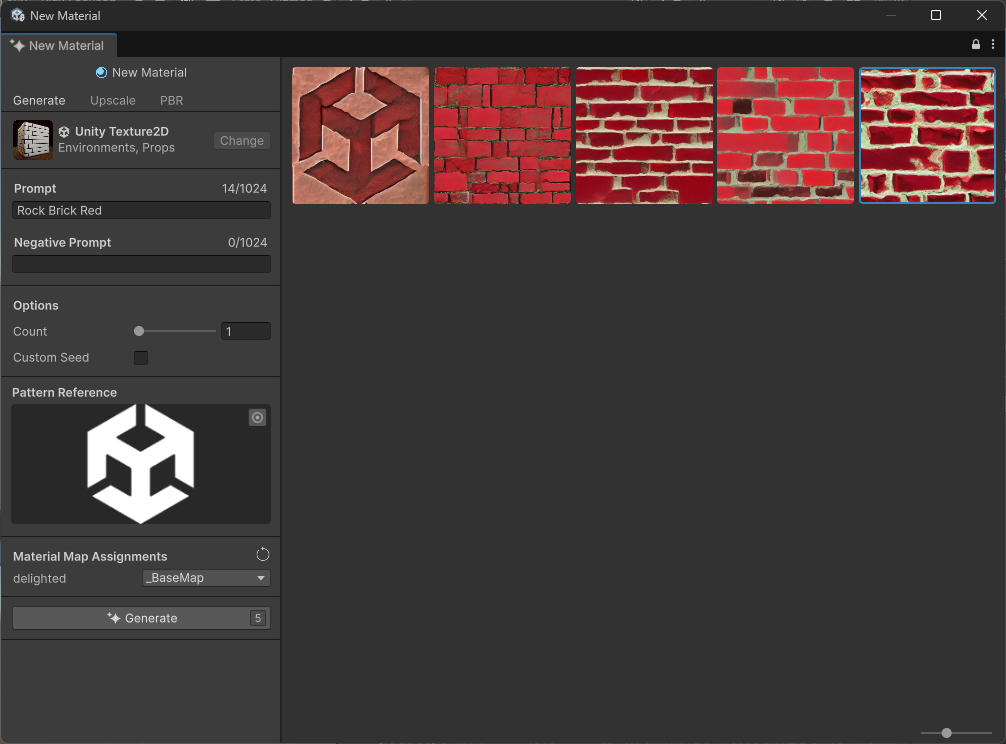

2-6-1. Generate

通常のプロンプトに加えネガティブプロンプトも対応しています。

またパターン参照(画像参照)もできます。

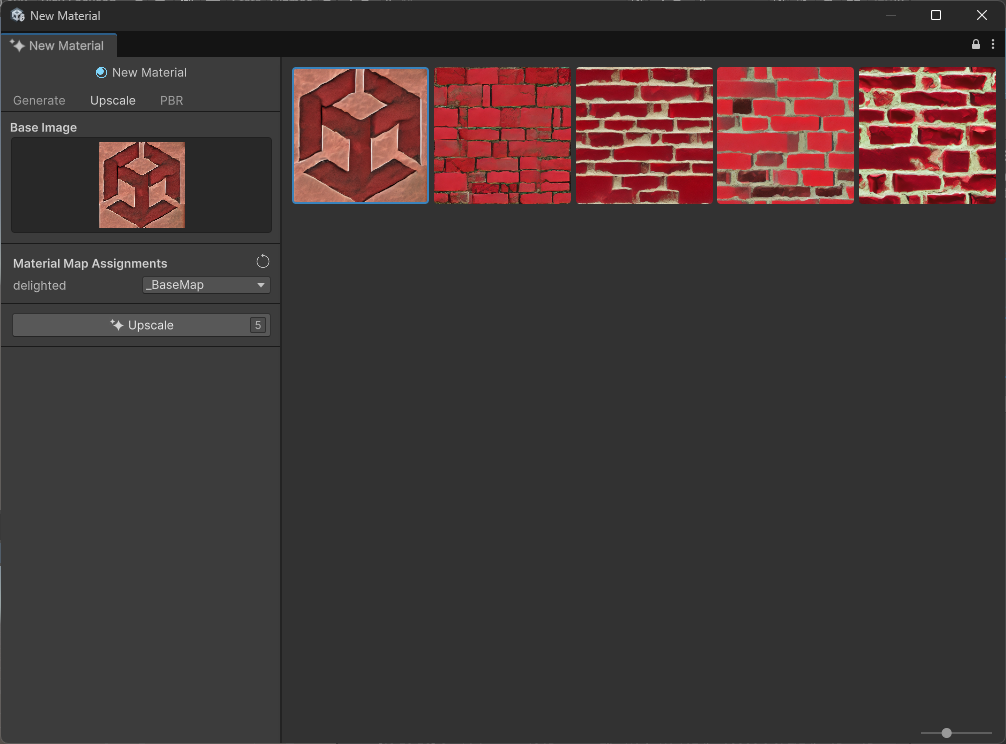

2-6-2. Upscale

所謂AIアプコン。解像度を高くしても画質を落とさない出力です。

入力画像が倍の解像度で変換されます。

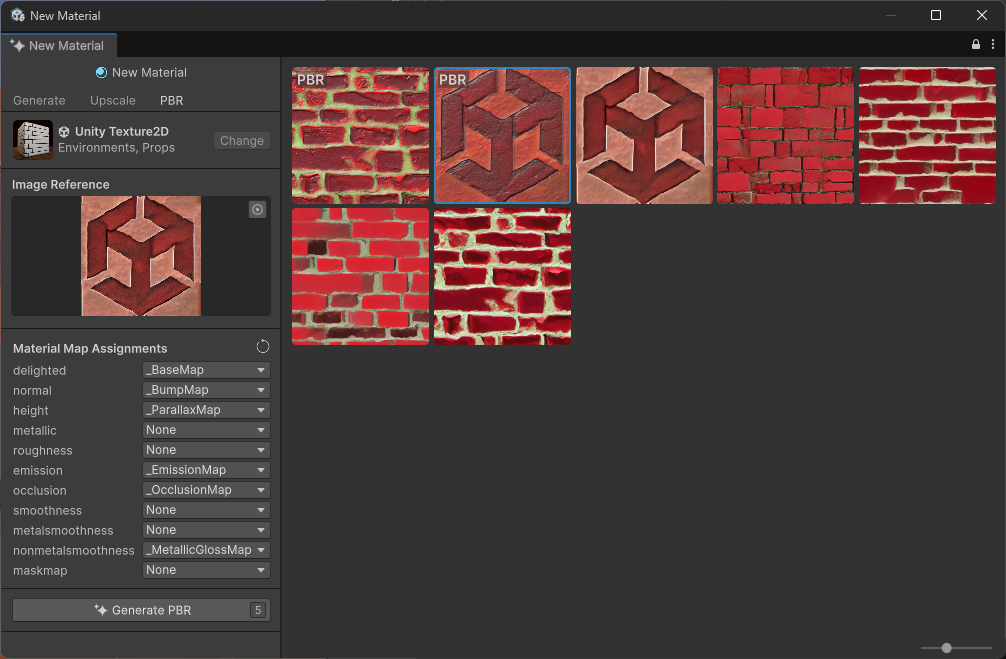

2-6-3. PBR

入力画像からPBRのテクスチャ(NormalMap, HeightMapなど)を作成します。

.pngで画像が書き出されます。

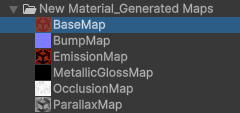

2-7. Sound Generate

テキストから音声ファイル(.wav)を生成できます。

ネガティブプロンプトも対応しています。

またAudio Clipから生成も可能です。Audio Clip以外にもマイクからレコードできます。

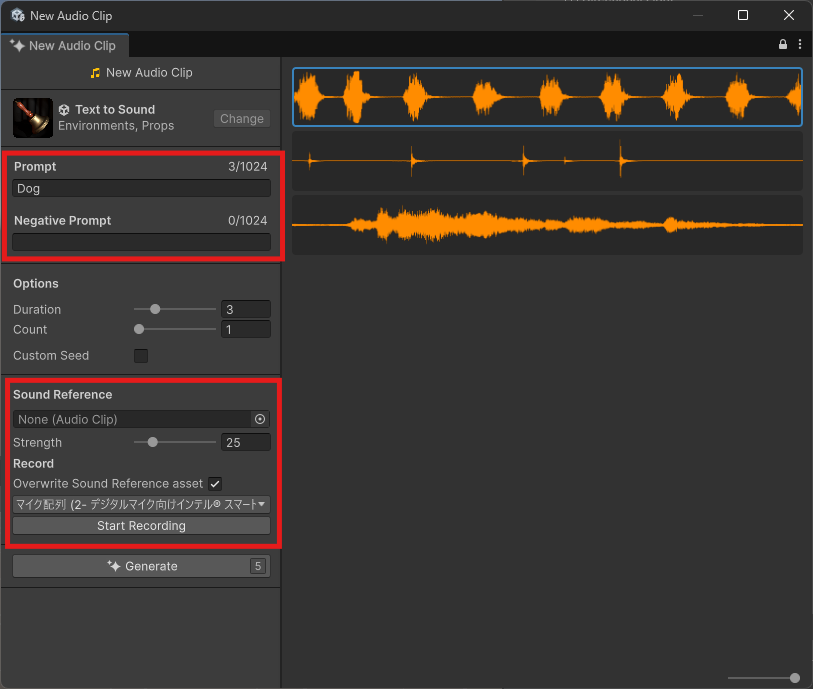

2-8. Sprite & Texture Generate

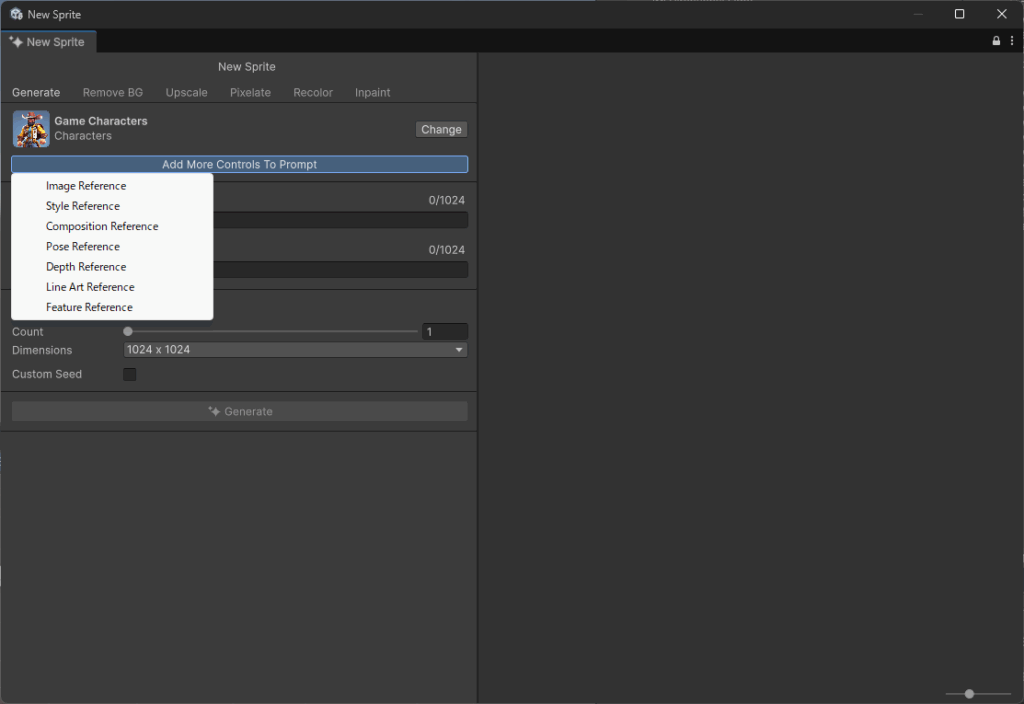

2-8-1. Generate

モデルを選択できます。生成される絵柄が変更されます。

Text to Textureで生成可能です。

モデルによってはリファレンスを追加できるものがあります。

- Image Reference

- 画像参照。入力画像にエディタ上で描いた絵も参照できる

- Style Reference

- スタイル画像参照

- Composition Reference

- 生成された画像内の要素の空間配置に影響

- Pose Reference

- ポーズ画面参照

- Depth Reference

- 参照画像に基づいて、生成された画像に深度情報を追加

- Line Art Reference

- 出力イメージを参照イメージのライン アート スタイルに合わせるように条件付け

- Feature Reference

- 色のパターンや形状など、参照画像の特定の視覚的詳細を生成された画像に一致

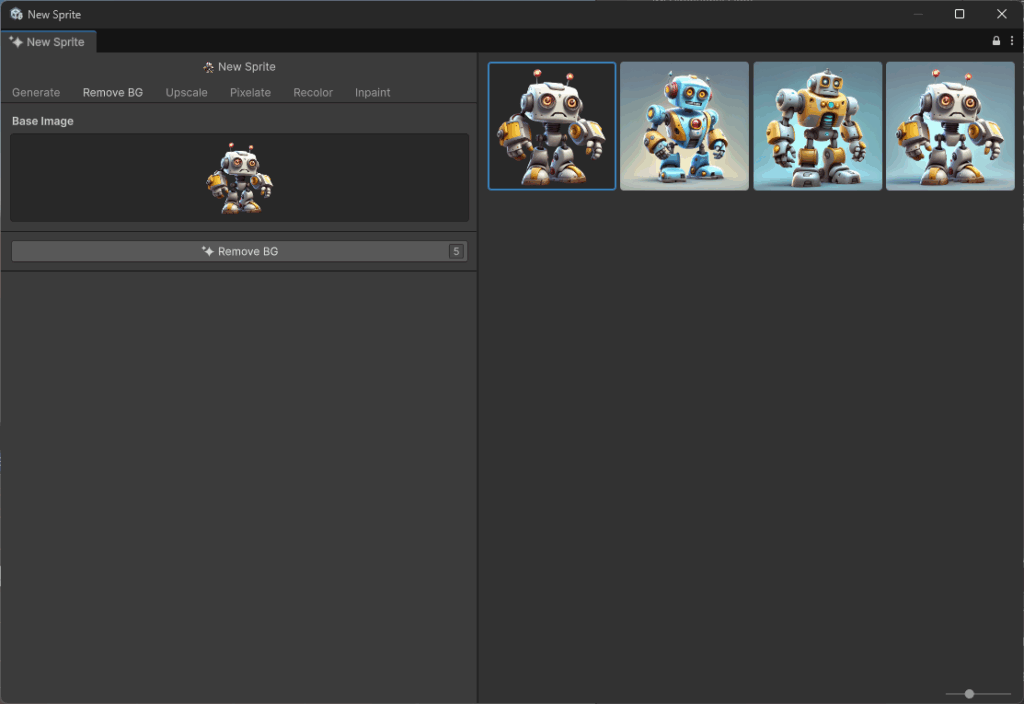

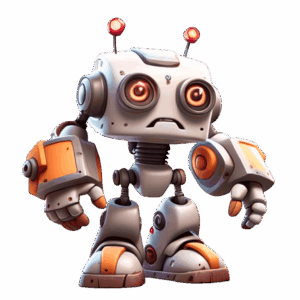

2-8-2. RemoveBG

背景を消すことができます

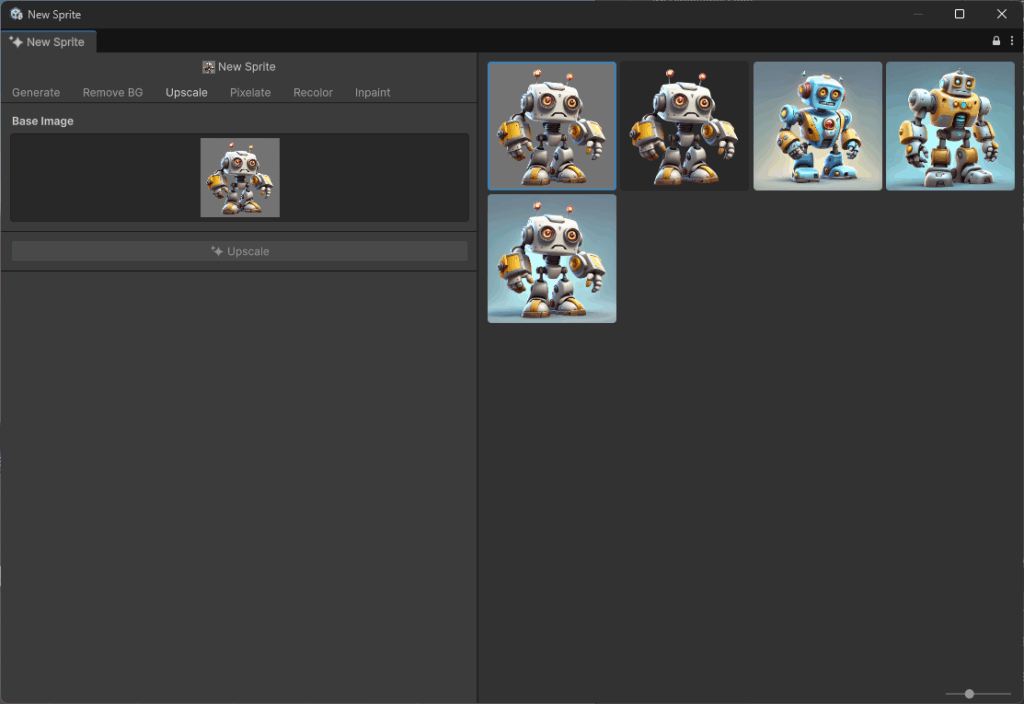

2-8-3. Upscale

所謂AIアプコン。解像度を高くしても画質を落とさない出力です。

入力画像が倍の解像度で変換されます。

1024×1024から2048×2048に変換されていました。

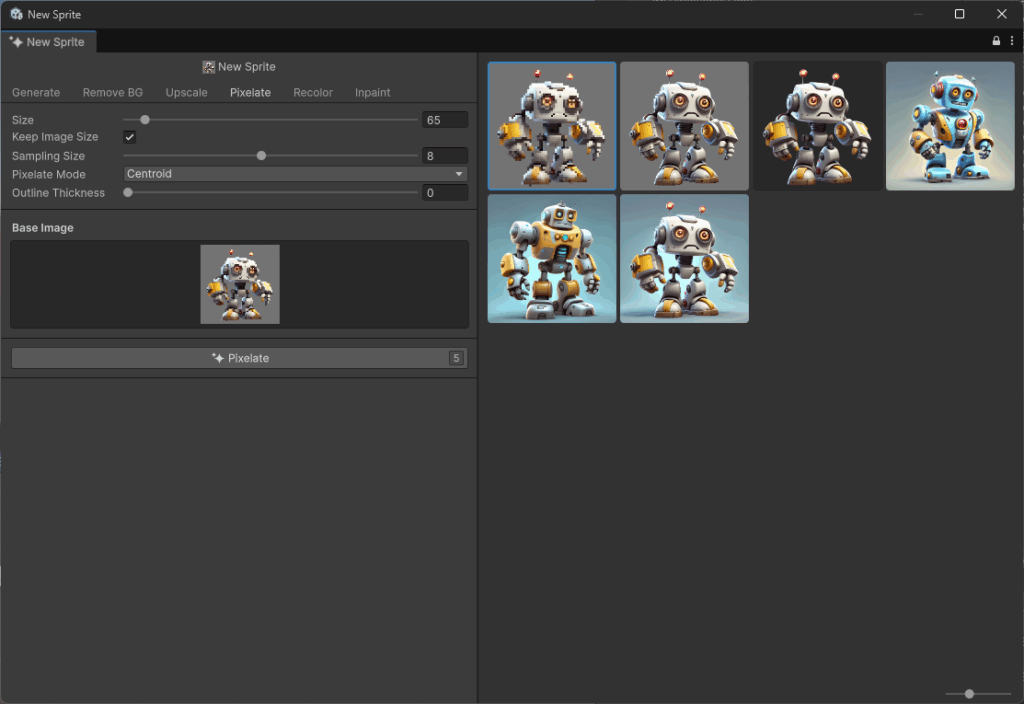

2-8-4. Pixelate

ピクセレート処理(低解像度エフェクト)をすることができます。

画像の解像度が変更されるわけではなくピクセレートエフェクトがかかります。

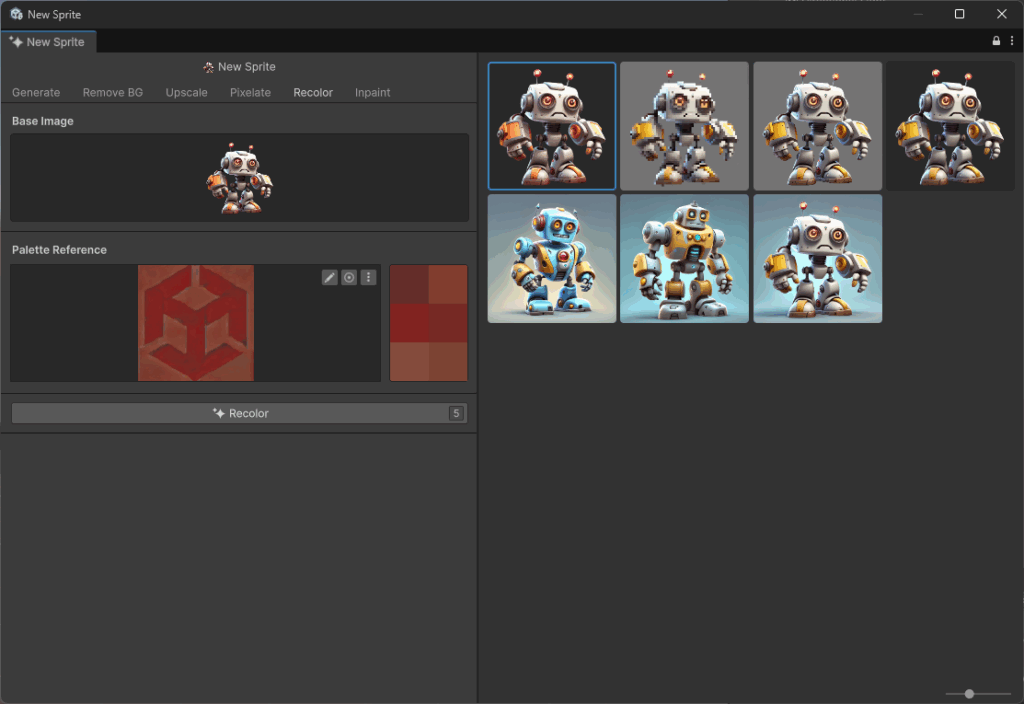

2-8-5. Recolor

色の変更ができます。画像参照や直にエディタ上で色入力(絵を描く)することも可能です。

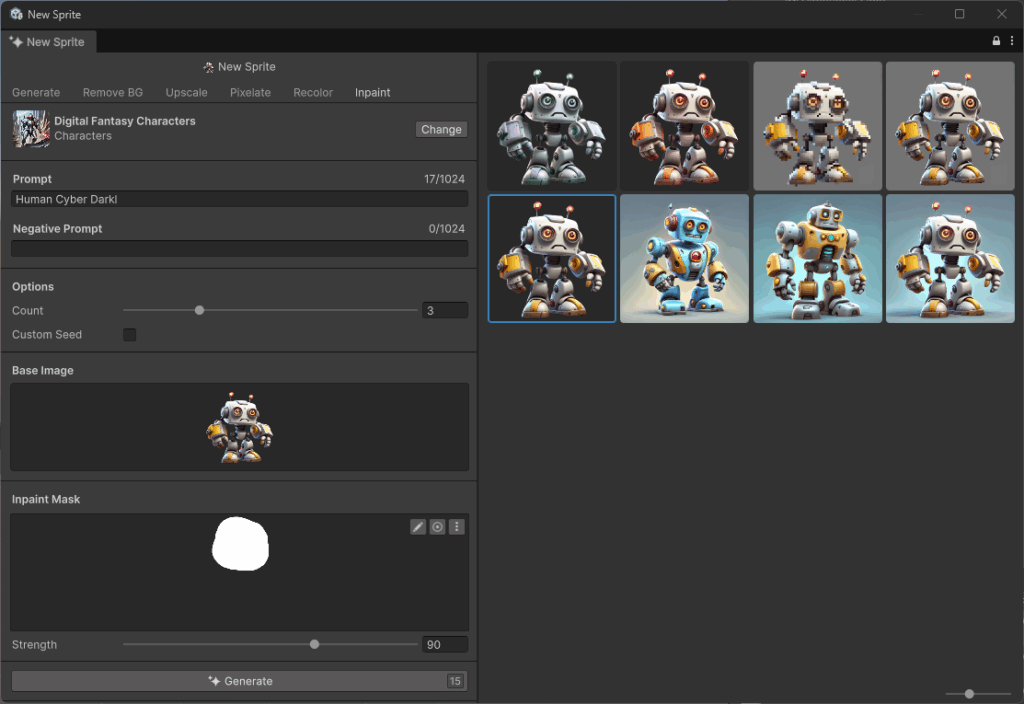

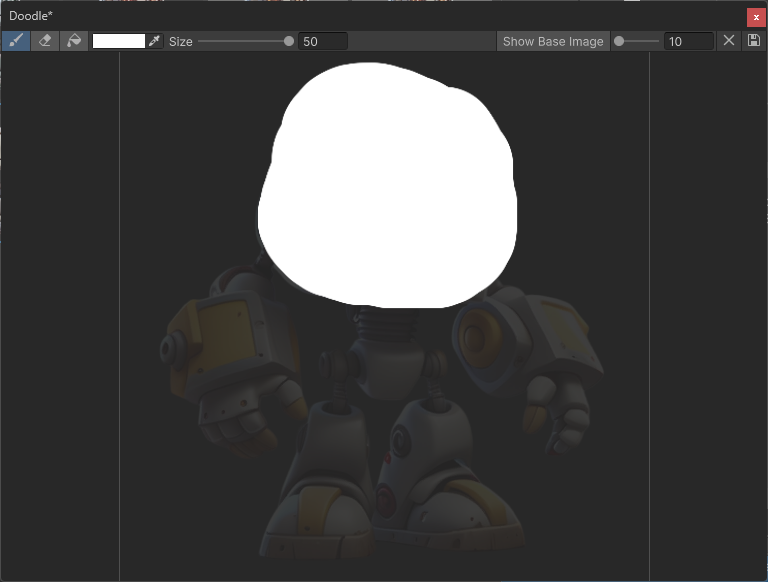

2-8-6. Inpaint

画像の一部を修正することができます。

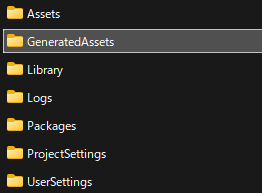

2-9. 生成したファイルについて

プロジェクト直下のGeneratedAssetsフォルダに生成したすべてのファイルの生データが格納されていました。

画像ならpng、音ならwav、アニメーションならfbx

3. 旧Unity Sentisの機能

3-1. 概要

現在はUnity Interface Engineに名称変更されています。

ランタイム向けに機械学習データを使うためのパッケージです。

ONNX形式のモデルをサポートしており(既存のモデルを使用可能)ゲームに以下のような機能を組み込むことが可能です。

例

- 物体検知

- カスタマイズ可能な AI 対戦相手

- 手書き検出

- 深度推定

- 音声認識

- NPCとの会話

詳しくは以下の動画を見るとわかりやすいです。

3-2. インストール方法

Unity 6000.0.40f1以上をダウンロードし、パッケージマネージャーからInterface Engineをインストールする。

(Unity 6.2ではデフォルトでインストールされていました)

3-3. 公式サンプル

Unity公式がGitHubにサンプルプロジェクトを上げています。

https://github.com/Unity-Technologies/inference-engine-samples

3-3-1. BlazeDetectionSample

顔・手・身体のボーン検知などができます。

参照する画像はTextureクラスなのでRenderTexture, WebCamTextureなどのクラスに対応してます。

サンプルから簡単な変更でできました。

フレームレートはUnityのメインスレッドとは別スレッドで動いてるっぽいので爆速でした。

3-3-2. BoardGameAISample

ボードゲームのサンプル

3-3-3. DepthEstimationSample

画像から深度情報を取得するサンプル。

ステレオカメラなわけではなく、通常のウェブカメラで動作可能でした。

3-3-4. DigitRecognitionSample

ユーザーが描いた文字から数字として認識するサンプル。

4. まとめ

アシスタントチャットが独自のUnityプロジェクトの詳細まで把握してくれるので他のチャットAIと比べてより深い質問や作業をお願いできる。

また生成AIに関してはUnityがあればほかのAIツールを使用しなくUnityエディター1つで完結できるのがUnity AIを使うメリットだと思いました。

Unity AIを使うことでエンジニアだけでプロトタイピングのクオリティやスピード向上などが期待できそうです。

一方で本実装ではクオリティ的にそのまま利用することは難しそうです。